L’attuale tecnologia di visione notturna ha le sue insidie: è utile, ma è in gran parte monocromatica, il che rende difficile identificare correttamente cose e persone. Per fortuna, la visione notturna sembra essersi rinnovata con una visibilità a colori resa possibile dal deep learning.

Gli scienziati dell’Università della California, a Irvine, hanno sperimentato la ricostruzione di scene di visione notturna a colori utilizzando un algoritmo di deep learning. L’algoritmo utilizza immagini a infrarossi invisibili ad occhio nudo; gli esseri umani possono vedere solo onde luminose da circa 400 nanometri (quello che vediamo come viola) a 700 nanometri (rosso), mentre i dispositivi a infrarossi possono vedere fino a un millimetro. L’infrarosso è quindi una componente essenziale della tecnologia di visione notturna, in quanto consente agli esseri umani di “vedere” ciò che normalmente percepiremmo come oscurità totale.

Sebbene la termografia sia stata precedentemente utilizzata per colorare le scene catturate a infrarossi, non è nemmeno perfetta. L’imaging termico utilizza una tecnica chiamata pseudocolore per “mappare” ogni sfumatura da una scala monocromatica al colore, il che si traduce in un’immagine utile ma altamente irrealistica. Questo non risolve il problema dell’identificazione di oggetti e individui in condizioni di scarsa o scarsa illuminazione.

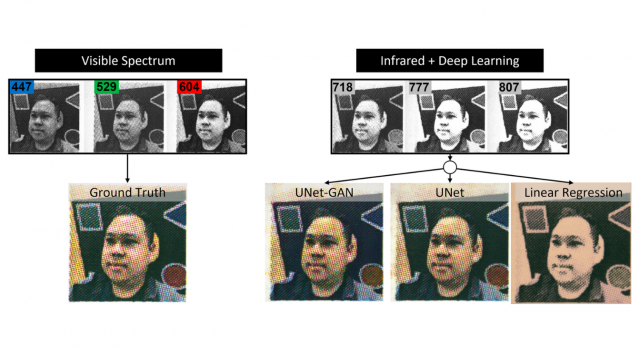

Gli scienziati dell’UC Irvine, d’altra parte, hanno cercato di creare una soluzione in grado di produrre un’immagine simile a quella che un essere umano vedrebbe nella luce dello spettro visibile. Hanno utilizzato una fotocamera monocromatica sensibile alla luce del visibile e del vicino infrarosso per catturare fotografie di tavolozze di colori e volti. Hanno quindi addestrato una rete neurale convoluzionale per prevedere le immagini dello spettro visibile utilizzando solo le immagini del vicino infrarosso fornite. Il processo di addestramento ha prodotto tre architetture: una regressione lineare di base, una CNN (UNet) ispirata a U-Net e una U-Net aumentata (UNet-GAN), ciascuna delle quali è stata in grado di produrre circa tre immagini al secondo.

Una volta che la rete neurale ha prodotto immagini a colori, il team, composto da ingegneri, scienziati della vista, chirurghi, informatici e studenti di dottorato, ha fornito le immagini ai selezionatori, che hanno selezionato quali output soggettivamente apparivano più simili all’immagine della verità di base. Questo feedback ha aiutato il team a selezionare quale architettura di rete neurale fosse più efficace, con UNet che ha superato UNet-GAN tranne che in condizioni di zoom avanti.

Il team della UC Irvine ha pubblicato mercoledì i risultati sulla rivista PLOS ONE. Sperano che la loro tecnologia possa essere applicata alla sicurezza, alle operazioni militari e all’osservazione degli animali, anche se la loro esperienza dice loro che potrebbe essere applicabile per ridurre i danni alla vista durante gli interventi chirurgici agli occhi.